) pretende comparar exclusivamente dos poblaciones. Sin embargo, a menudo se utiliza incorrectamente para comparaciones por pares de un mayor número de grupos (Fig. 1), lo que provoca el llamado. efecto de comparación múltiple(Inglés) comparaciones múltiples; Glanz 1999, pág. 101-104). Hablaremos de este efecto y de cómo afrontarlo más adelante. En el mismo post describiré los principios. Análisis de varianza de una sola vía, sólo destinado a simultáneo comparar las medias de dos o más grupos. Principios del análisis de varianza. un análisis oh F Virginia riance, ANOVA) se desarrollaron en la década de 1920. Sir Ronald Aylmer Fisher Ronald Aylmer Fisher) - "un genio que casi por sí solo sentó las bases de la estadística moderna" (Hald 1998).

Puede surgir la pregunta: ¿por qué se utiliza el método de comparación? promedio valores se llama dispersivo¿análisis? El caso es que al establecer la diferencia entre valores promedio, en realidad estamos comparando las varianzas de las poblaciones analizadas. Sin embargo, lo primero es lo primero...

Formulación del problema

El siguiente ejemplo está tomado del libro. Maindonald & Braun(2010). Existen datos sobre el peso de tomates (planta entera; peso, en kg), que fueron cultivados durante 2 meses en tres condiciones experimentales diferentes (trt, de tratamiento) - en agua (agua), en un ambiente con la adición de fertilizante (nutriente), así como en un ambiente con la adición de fertilizante y herbicida 2,4-D (nutriente+24D):

# Crea una tabla con datos: tomate<- data.frame (weight= c (1.5 , 1.9 , 1.3 , 1.5 , 2.4 , 1.5 , # water 1.5 , 1.2 , 1.2 , 2.1 , 2.9 , 1.6 , # nutrient 1.9 , 1.6 , 0.8 , 1.15 , 0.9 , 1.6 ) , # nutrient+24D trt = rep (c ("Water" , "Nutrient" , "Nutrient+24D" ) , c (6 , 6 , 6 ) ) ) # Veamos el resultado: peso peso trt 1 1,50 Agua 2 1,90 Agua 3 1,30 Agua 4 1,50 Agua 5 2,40 Agua 6 1,50 Agua 7 1,50 Nutriente 8 1,20 Nutriente 9 1,20 Nutriente 10 2,10 Nutriente 11 2,90 Nutriente 12 1,60 Nutriente 13 1,90 Nutriente+24 D 14 1.60 Nutriente+24D 15 0,80 Nutriente+24D 16 1,15 Nutriente+24D 17 0,90 Nutriente+24D 18 1,60 Nutriente+24D

La variable trt es un factor con tres niveles. Para una comparación más clara de las condiciones experimentales en el futuro, haremos que el nivel de "agua" sea el nivel base. referencia), es decir. el nivel con el que R comparará todos los demás niveles. Esto se puede hacer usando la función relevel():

Para comprender mejor las propiedades de los datos disponibles, visualicémoslos usando las diferencias observadas entre las medias de los grupos, que son insignificantes y causadas por la influencia de factores aleatorios (es decir, en realidad, todas las mediciones de peso de las plantas obtenidas provienen de una población distribuida normalmente):

Enfaticemos una vez más que el ejemplo considerado corresponde al caso factor único Análisis de varianza: se estudia el efecto de un factor - condiciones de crecimiento (con tres niveles - Agua, Nutriente y Nutriente + 24D) sobre la variable respuesta que nos interesa - peso de la planta.

Desafortunadamente, un investigador casi nunca tiene la oportunidad de estudiar a toda la población. Entonces, ¿cómo sabemos si la hipótesis nula anterior es cierta solo con datos de muestra? Podemos formular esta pregunta de otra manera: ¿Cuál es la probabilidad de obtener las diferencias observadas entre las medias de los grupos al extraer muestras aleatorias de una única población distribuida normalmente?? Para responder a esta pregunta, necesitamos un criterio estadístico que caracterice cuantitativamente la magnitud de las diferencias entre los grupos comparados.

El análisis de varianza es un método estadístico para evaluar la relación entre factores y características de desempeño en diferentes grupos, seleccionados al azar, basado en la determinación de las diferencias (diversidad) en los valores de las características. El análisis de varianza se basa en el análisis de las desviaciones de todas las unidades de la población en estudio de la media aritmética. Como medida de las desviaciones, se toma la dispersión (B), el cuadrado promedio de las desviaciones. Las desviaciones causadas por la influencia de un atributo de factor (factor) se comparan con la magnitud de las desviaciones causadas por circunstancias aleatorias. Si las desviaciones causadas por una característica de un factor son más significativas que las desviaciones aleatorias, entonces se considera que el factor tiene un impacto significativo en la característica resultante.

Para calcular la dispersión se elevan al cuadrado los valores de desviación de cada opción (cada valor numérico registrado de la característica) de la media aritmética. Esto elimina los signos negativos. Luego, estas desviaciones (diferencias) se suman y se dividen por el número de observaciones, es decir desviaciones promedio. Así, se obtienen los valores de varianza.

Una importancia metodológica importante para el uso del análisis de varianza es la correcta selección de la muestra. Dependiendo de la meta y los objetivos, los grupos de muestra se pueden formar aleatoriamente e independientemente unos de otros (grupos de control y experimentales para estudiar algún indicador, por ejemplo, el efecto de la presión arterial alta en el desarrollo de un accidente cerebrovascular). Estas muestras se denominan independientes.

A menudo, los resultados de la exposición a factores se estudian en el mismo grupo de muestra (por ejemplo, los mismos pacientes) antes y después de la exposición (tratamiento, prevención, medidas de rehabilitación); dichas muestras se denominan dependientes.

El análisis de varianza, que prueba la influencia de un factor, se denomina análisis unifactorial (análisis univariante). Cuando se estudia la influencia de más de un factor se utiliza un método multifactorial. Análisis de variación(analisis multivariable).

Las características de los factores son aquellas características que influyen en el fenómeno que se estudia.

Las características efectivas son aquellas características que cambian bajo la influencia de las características de los factores.

Condiciones para utilizar el análisis de varianza:

El objetivo del estudio es determinar la fuerza de la influencia de uno (hasta 3) factores en el resultado o determinar la fuerza de la influencia combinada de varios factores (sexo y edad, actividad física y nutrición, etc.).

Los factores que se estudian deben ser independientes (no relacionados) entre sí. Por ejemplo, es imposible estudiar la influencia conjunta de la experiencia laboral y la edad, altura y peso de los niños, etc. sobre la morbilidad de la población.

La selección de grupos para el estudio se realiza de forma aleatoria (selección aleatoria). La organización de un complejo de dispersión con la implementación del principio de aleatoriedad en la selección de opciones se llama aleatorización (traducido del inglés - aleatorio), es decir elegido al azar.

Se pueden utilizar características tanto cuantitativas como cualitativas (atributivas).

Al realizar un análisis de varianza unidireccional, se recomienda (una condición necesaria para su uso):

1. Normalidad de distribución de los grupos analizados o correspondencia de los grupos de muestra con poblaciones generales con distribución normal.

2. Independencia (no relación) de la distribución de observaciones en grupos.

3. Disponibilidad de frecuencia (repetición) de observaciones.

En primer lugar se formula una hipótesis nula, es decir, se supone que los factores en estudio no tienen ningún efecto sobre los valores de la característica resultante y las diferencias obtenidas son aleatorias.

Luego determinamos cuál es la probabilidad de obtener las diferencias observadas (o más fuertes), siempre que la hipótesis nula sea verdadera.

Si esta probabilidad es pequeña, entonces rechazamos la hipótesis nula y concluimos que los resultados del estudio son estadísticamente significativos. Esto no significa que se haya demostrado el efecto de los factores estudiados (se trata, en primer lugar, de la planificación de la investigación), pero aún es poco probable que el resultado se deba al azar.

Si se cumplen todas las condiciones para aplicar el análisis de varianza, la descomposición matemática de la varianza total se ve así:

ext. = Dhecho + D resto.,

ext. - la dispersión total de los valores observados (variante), caracterizada por la dispersión de la variante respecto del promedio general. Mide la variación de un rasgo en su totalidad bajo la influencia de todos los factores que causaron esta variación. La diversidad general consiste en diversidad intergrupal e intragrupal;

Dfact - dispersión factorial (intergrupo), caracterizada por la diferencia de medias en cada grupo y depende de la influencia del factor en estudio, por el cual se diferencia cada grupo. Por ejemplo, en grupos que difieren en el factor etiológico del curso clínico de la neumonía, el nivel promedio de días de cama no es el mismo: se observa diversidad entre grupos.

D descanso. - varianza residual (intragrupo), que caracteriza la dispersión de la variante dentro de los grupos. Refleja variación aleatoria, es decir parte de la variación que se produce bajo la influencia de factores no especificados y no depende de la característica, el factor que forma la base del grupo. La variación del rasgo estudiado depende de la fuerza de la influencia de algunos factores aleatorios no contabilizados, tanto organizados (establecidos por el investigador) como aleatorios (desconocidos).

Por lo tanto, la variación total (varianza) consiste en la variación causada por factores organizados (dados), llamados variación factorial y factores no organizados, es decir. variación residual (aleatoria, desconocida).

Para un tamaño de muestra n, la varianza de la muestra se calcula como la suma de las desviaciones al cuadrado de la media de la muestra dividida por n-1 (tamaño de la muestra menos uno). Así, para un tamaño de muestra fijo n, la varianza es función de la suma de cuadrados (desviaciones), denotada, por brevedad, SS (del inglés Sum of Squares). En lo que sigue, a menudo omitimos la palabra muestra, sabiendo muy bien que estamos considerando la varianza muestral o la estimación de la varianza. El análisis de varianza se basa en dividir la varianza en partes o componentes. Considere el siguiente conjunto de datos:

Las medias de los dos grupos son significativamente diferentes (2 y 6, respectivamente). La suma de las desviaciones al cuadrado dentro de cada grupo es 2. Sumándolas, obtenemos 4. Si ahora repetimos estos cálculos sin tener en cuenta la pertenencia al grupo, es decir, si calculamos SS con base en el promedio general de estas dos muestras, obtenemos obtenga un valor de 28. En otras palabras, la varianza (suma de cuadrados) basada en la variabilidad dentro del grupo da como resultado valores mucho más pequeños que los calculados en función de la variabilidad general (en relación con la media general). La razón de esto es obviamente una diferencia significativa entre las medias, y esta diferencia entre las medias explica la diferencia existente entre las sumas de cuadrados.

| SS | St.St. | EM | F | pag | |

| Efecto | 24.0 | 24.0 | 24.0 | .008 | |

| Error | 4.0 | 1.0 |

Como se puede ver en la tabla, cantidad total cuadrados SS = 28 se divide en componentes: la suma de cuadrados debido a la variabilidad intragrupo (2+2=4; ver la segunda fila de la tabla) y la suma de cuadrados debido a la diferencia de valores medios entre grupos (28 -(2+2)=24; ver la primera fila de la tabla). Tenga en cuenta que MS en esta tabla es el cuadrado medio igual a SS dividido por el número de grados de libertad (gl).

En el ejemplo simple anterior, podría calcular inmediatamente la prueba t para muestras independientes. Los resultados obtenidos naturalmente coincidirán con los resultados del análisis de varianza.

Sin embargo, las situaciones en las que un determinado fenómeno se describe completamente mediante una variable son extremadamente raras. Por ejemplo, si estamos intentando aprender a cultivar tomates grandes, debemos considerar factores relacionados con la estructura genética de la planta, el tipo de suelo, la luz, la temperatura, etc. Por tanto, al realizar un experimento típico, hay que tener en cuenta una gran cantidad de factores. La razón principal por la que es preferible utilizar ANOVA a comparaciones repetidas de dos muestras con diferentes niveles de factores utilizando una serie de pruebas t es que ANOVA es sustancialmente más eficiente y, para muestras pequeñas, más informativo.

Supongamos que en el ejemplo de análisis de dos muestras analizado anteriormente, agregamos otro factor, por ejemplo, Género. Ahora cada grupo estará formado por 3 hombres y 3 mujeres. El plan de este experimento se puede presentar en forma de tabla:

Antes de hacer los cálculos, puedes observar que en este ejemplo la varianza total tiene al menos tres fuentes:

1) error aleatorio (varianza intragrupo),

2) variabilidad asociada a la pertenencia al grupo experimental

3) variabilidad por el género de los objetos de observación.

Tenga en cuenta que existe otra posible fuente de variabilidad: la interacción de factores, que analizaremos más adelante). ¿Qué sucede si no incluimos el género como factor en el análisis y calculamos una prueba t regular? Si calculamos sumas de cuadrados ignorando el género (es decir, combinando objetos de diferentes géneros en un grupo al calcular la varianza dentro del grupo y obteniendo una suma de cuadrados para cada grupo igual a SS = 10 y una suma total de cuadrados SS = 10+10 = 20), entonces obtendremos un valor mayor de varianza dentro del grupo que con un análisis más preciso con división adicional en subgrupos por género (en este caso, las medias dentro del grupo serán iguales a 2, y el total dentro del grupo suma de cuadrados será igual a SS = 2+2+2+2 = 8).

Entonces, con la introducción de un factor adicional: el género, la varianza residual disminuyó. Esto se debe a que la media de los hombres es menor que la media de las mujeres, y esta diferencia de medias aumenta la variabilidad general dentro del grupo cuando no se tiene en cuenta el género. Controlar la varianza del error aumenta la sensibilidad (potencia) de la prueba.

Este ejemplo muestra otra ventaja del análisis de varianza en comparación con la prueba t habitual de dos muestras. El análisis de varianza permite estudiar cada factor controlando los valores de otros factores. Esta es, de hecho, la razón principal de su mayor poder estadístico (se requieren tamaños de muestra más pequeños para obtener resultados significativos). Por esta razón, el análisis de varianza, incluso en muestras pequeñas, produce resultados estadísticamente más significativos que una simple prueba t.

Ejercicio . Se encuestó a los estudiantes de 1er año para identificar las actividades a las que dedican su tiempo libre. Compruebe si la distribución de las preferencias verbales y no verbales de los estudiantes difiere.Solución realizado mediante una calculadora.

Encontrar promedios de grupo:

| norte | P 1 | P 2 |

| 1 | 12 | 17 |

| 2 | 18 | 19 |

| 3 | 23 | 25 |

| 4 | 10 | 7 |

| 5 | 15 | 17 |

| x promedio | 15.6 | 17 |

Denotaremos p - el número de niveles del factor (p=2). El número de dimensiones en cada nivel es el mismo e igual a q=5.

La última fila contiene medias de grupo para cada nivel de factor.

El promedio general se puede obtener como la media aritmética de los promedios del grupo:

(1)

La distribución de los promedios grupales del porcentaje de fallas en relación con el promedio general está influenciada tanto por cambios en el nivel del factor considerado como por factores aleatorios.

Para tener en cuenta la influencia de este factor, la varianza total de la muestra se divide en dos partes, la primera de las cuales se llama factor S 2 f y la segunda se llama residual S 2 resto.

Para tener en cuenta estos componentes, primero se calcula la suma total de las desviaciones al cuadrado del promedio general:

y la suma factorial de las desviaciones al cuadrado de los promedios grupales del promedio general, que caracteriza la influencia de este factor:

La última expresión se obtiene reemplazando cada opción en la expresión R con la media total del grupo para un factor dado.

La suma residual de las desviaciones al cuadrado se obtiene como la diferencia:

R resto = R total - R f

Para determinar la varianza total de la muestra, es necesario dividir R total por el número de mediciones pq:

y para obtener la varianza muestral total insesgada, esta expresión debe multiplicarse por pq/(pq-1):

En consecuencia, para una varianza muestral de factores insesgada:

donde p-1 es el número de grados de libertad de la varianza muestral del factor insesgado.

Para evaluar la influencia de un factor sobre los cambios en el parámetro considerado, se calcula el valor:

Dado que la relación de dos varianzas muestrales S 2 f y S 2 rest se distribuye según la ley de Fisher-Snedecor, el valor resultante de f obs se compara con el valor de la función de distribución.

en el punto crítico f cr correspondiente al nivel de significancia seleccionado a.

Si f obs > f cr, entonces el factor tiene un impacto significativo y debe tenerse en cuenta; de lo contrario, tiene un efecto insignificante que puede despreciarse.

Para calcular Rob y Rf también se pueden utilizar las siguientes fórmulas:

Encontramos el promedio general usando la fórmula (1):

Para calcular Rtot usando la fórmula (4), elaboramos una tabla de 2 cuadrados: opción:

| norte | P 2 1 | P 2 2 |

| 1 | 144 | 289 |

| 2 | 324 | 361 |

| 3 | 529 | 625 |

| 4 | 100 | 49 |

| 5 | 225 | 289 |

| ∑ | 1322 | 1613 |

El promedio general se calcula mediante la fórmula (1):

Rtot = 1322 + 1613 - 5 2 16,3 2 = 278,1

Encontramos R f usando la fórmula (5):

R f = 5(15,6 2 + 17 2) - 2 16,3 2 = 4,9

Obtenemos R resto: R resto = R total - R f = 278,1 - 4,9 = 273,2

Determinamos las varianzas factoriales y residuales:

Si los valores promedio variable aleatoria, calculados para muestras individuales son iguales, entonces las estimaciones del factor y las varianzas residuales son estimaciones insesgadas de la varianza general y difieren de manera insignificante.

Entonces, una comparación de las estimaciones de estas varianzas utilizando el criterio de Fisher debería mostrar que no hay razón para rechazar la hipótesis nula sobre la igualdad de las varianzas factorial y residual.

La estimación de dispersión de factores es menor que la estimación de dispersión residual, por lo que podemos afirmar inmediatamente la validez de la hipótesis nula de igualdad. expectativas matemáticas mediante capas de muestreo.

En otras palabras, en este ejemplo, el factor Ф no tiene un efecto significativo sobre la variable aleatoria.

Comprobemos la hipótesis nula H 0: igualdad de los valores medios de x.

Encuentra f obs.

Para el nivel de significancia α=0,05, grados de libertad números 1 y 8, encontramos fcr en la tabla de distribución de Fisher-Snedecor.

f cr (0,05; 1; 8) = 5,32

Debido al hecho de que f observó< f кр, нулевую гипотезу о существенном влиянии фактора на результаты экспериментов отклоняем.

En otras palabras, la distribución de las preferencias verbales y no verbales de los estudiantes difiere.

Ejercicio. La planta cuenta con cuatro líneas para la producción de baldosas de revestimiento. De cada línea, se seleccionaron aleatoriamente 10 baldosas durante un turno y se midió su espesor (mm). Las desviaciones del tamaño nominal se dan en la tabla. Se requiere establecer con un nivel de significancia de a = 0,05 que existe una dependencia de la producción de baldosas de alta calidad de la línea de producción (factor A).

Ejercicio. Con un nivel de significancia de a = 0.05, investigue el efecto del color de la pintura sobre la vida útil del recubrimiento.

Ejemplo No. 1. Se realizaron 13 pruebas, de las cuales 4 fueron al nivel del primer factor, 4 al segundo, 3 al tercero y 2 al cuarto. Utilizando el método de análisis de varianza a un nivel de significancia de 0,05, pruebe la hipótesis nula sobre la igualdad de las medias grupales. Se supone que las muestras provienen de poblaciones normales con varianzas iguales. Los resultados de la prueba se muestran en la tabla.

Solución:

Encontrar promedios de grupo:

| norte | P 1 | P 2 | P 3 | P 4 |

| 1 | 1.38 | 1.41 | 1.32 | 1.31 |

| 2 | 1.38 | 1.42 | 1.33 | 1.33 |

| 3 | 1.42 | 1.44 | 1.34 | - |

| 4 | 1.42 | 1.45 | - | - |

| ∑ | 5.6 | 5.72 | 3.99 | 2.64 |

| x promedio | 1.4 | 1.43 | 1.33 | 1.32 |

Denotaremos p - el número de niveles del factor (p=4). El número de dimensiones en cada nivel es: 4,4,3,2

La última fila contiene medias de grupo para cada nivel de factor.

El promedio general se calcula mediante la fórmula:

Para calcular Stotal usando la fórmula (4), elaboramos una tabla de 2 cuadrados: opción:

| norte | P 2 1 | P 2 2 | P 2 3 | P 2 4 |

| 1 | 1.9 | 1.99 | 1.74 | 1.72 |

| 2 | 1.9 | 2.02 | 1.77 | 1.77 |

| 3 | 2.02 | 2.07 | 1.8 | - |

| 4 | 2.02 | 2.1 | - | - |

| ∑ | 7.84 | 8.18 | 5.31 | 3.49 |

La suma total de las desviaciones al cuadrado se encuentra mediante la fórmula:

Encontramos S f usando la fórmula:

Obtenemos S resto: S resto = S total - S f = 0,0293 - 0,0263 = 0,003

Determinamos el factor de dispersión:

y varianza residual:

Si los valores promedio de una variable aleatoria calculados para muestras individuales son los mismos, entonces las estimaciones del factor y las varianzas residuales son estimaciones insesgadas de la varianza general y no difieren significativamente.

Entonces, una comparación de las estimaciones de estas varianzas utilizando el criterio de Fisher debería mostrar que no hay razón para rechazar la hipótesis nula sobre la igualdad de las varianzas factorial y residual.

La estimación de la dispersión del factor es mayor que la estimación de la dispersión residual, por lo que podemos afirmar inmediatamente que la hipótesis nula sobre la igualdad de las expectativas matemáticas entre las capas de la muestra no es cierta.

En otras palabras, en este ejemplo, el factor Ф tiene una influencia significativa sobre la variable aleatoria.

Comprobemos la hipótesis nula H 0: igualdad de los valores medios de x.

Encuentra f obs.

Para el nivel de significancia α=0,05, grados de libertad números 3 y 12, encontramos fcr en la tabla de distribución de Fisher-Snedecor.

f cr (0,05; 3; 12) = 3,49

Debido a que f observado > f cr, aceptamos la hipótesis nula sobre la influencia significativa del factor en los resultados de los experimentos (rechazamos la hipótesis nula sobre la igualdad de las medias grupales). En otras palabras, las medias del grupo en su conjunto difieren significativamente.

Ejemplo No. 2. La escuela tiene 5 sextos grados. El psicólogo tiene la tarea de determinar si el nivel medio de ansiedad situacional es el mismo en las clases. Para ello se dieron en la tabla. Comprobar el nivel de significancia α=0,05, el supuesto de que la ansiedad situacional promedio en clases no difiere.

Ejemplo No. 3. Para estudiar el valor de X, se realizaron 4 pruebas en cada uno de los cinco niveles del factor F. Los resultados de las pruebas se muestran en la tabla. Descubra si la influencia del factor F sobre el valor de X es significativa. Considere α = 0,05. Se supone que las muestras provienen de poblaciones normales con varianzas iguales.

Ejemplo No. 4. Supongamos que en el experimento pedagógico participaron tres grupos de 10 estudiantes cada uno. Aplicado en grupos varios métodos formación: en el primero - tradicional (F 1), en el segundo - basado en tecnología informática (F 2), en el tercero - un método que utiliza ampliamente tareas para Trabajo independiente(F 3). Los conocimientos se evaluaron mediante un sistema de diez puntos.

Se requiere procesar los datos obtenidos del examen y llegar a una conclusión sobre si la influencia del método de enseñanza es significativa, tomando como nivel de significancia α = 0,05.

Los resultados del examen se dan en la tabla, F j es el nivel del factor x ij, la evaluación del i-ésimo estudiante utilizando el método F j.

|

Nivel de factor |

|||||||||||

Ejemplo No. 5. Se muestran los resultados de las pruebas competitivas de variedades de cultivos (rendimiento en centímetros por hectárea). Cada variedad fue probada en cuatro parcelas. Utilizando el análisis de varianza, estudie el efecto de la variedad sobre el rendimiento. Establezca la importancia de la influencia del factor (la proporción de la variación intergrupal en la variación total) y la importancia de los resultados experimentales en un nivel de significancia de 0,05.

Productividad en parcelas de ensayo de variedades.

| Variedad | Productividad por réplicas c. de ja | |||

| 1 | 2 | 3 | 4 | |

| 1 2 3 |

42,4 52,5 52,3 |

37,4 50,1 53,0 |

40,7 53,8 51,4 |

38,2 50,7 53,6 |

Análisis de variación

1. Concepto de análisis de varianza

Análisis de variación es un análisis de la variabilidad de un rasgo bajo la influencia de cualquier factor variable controlado. En la literatura extranjera, el análisis de varianza a menudo se denomina ANOVA, que se traduce como análisis de variabilidad (Análisis de Varianza).

problema de ANOVA Consiste en aislar la variabilidad de diferente tipo de la variabilidad general de un rasgo:

a) variabilidad por la acción de cada una de las variables independientes objeto de estudio;

b) variabilidad por la interacción de las variables independientes en estudio;

c) variabilidad aleatoria debido a todas las demás variables desconocidas.

La variabilidad debida a la acción de las variables en estudio y su interacción se correlaciona con la variabilidad aleatoria. Un indicador de esta relación es la prueba F de Fisher.

La fórmula para calcular el criterio F incluye estimaciones de varianzas, es decir, los parámetros de distribución del atributo, por lo que el criterio F es un criterio paramétrico.

Cuanto más se debe la variabilidad de un rasgo a las variables (factores) en estudio o a su interacción, mayor valores de criterio empírico.

Cero la hipótesis en el análisis de varianza afirmará que los valores promedio de la característica efectiva estudiada son los mismos en todas las gradaciones.

Alternativa la hipótesis afirmará que los valores promedio de la característica resultante en diferentes gradaciones del factor en estudio son diferentes.

El análisis de varianza nos permite indicar un cambio en una característica, pero no indica dirección estos cambios.

Comencemos nuestra consideración del análisis de varianza con el caso más simple, cuando estudiamos la acción de solo uno variable (un factor).

2. Análisis de varianza unidireccional para muestras no relacionadas

2.1. Propósito del método

El método de análisis de varianza de un factor se utiliza en los casos en que los cambios en una característica efectiva se estudian bajo la influencia de condiciones cambiantes o gradaciones de un factor. En esta versión del método, la influencia de cada una de las gradaciones del factor es diferente muestras de sujetos. Debe haber al menos tres gradaciones del factor. (Puede haber dos gradaciones, pero en este caso no podremos establecer dependencias no lineales y parece más razonable utilizar otras más sencillas).

Una versión no paramétrica de este tipo de análisis es la prueba H de Kruskal-Wallis.

Hipótesis

H 0: Las diferencias entre grados de factores (diferentes condiciones) no son mayores que las diferencias aleatorias dentro de cada grupo.

H 1: Las diferencias entre grados de factores (diferentes condiciones) son mayores que las diferencias aleatorias dentro de cada grupo.

2.2. Limitaciones del análisis de varianza unidireccional para muestras no relacionadas

1. El análisis de varianza unidireccional requiere al menos tres gradaciones del factor y al menos dos sujetos en cada gradación.

2. La característica resultante deberá distribuirse normalmente en la muestra objeto de estudio.

Es cierto que normalmente no se indica si estamos hablando de la distribución de la característica en toda la muestra encuestada o en la parte de ella que constituye el complejo de dispersión.

3. Un ejemplo de resolución de un problema utilizando el método de análisis de varianza unidireccional para muestras no relacionadas usando el ejemplo:

A tres grupos diferentes de seis sujetos se les dieron listas de diez palabras. Las palabras se presentaron al primer grupo a baja velocidad (1 palabra cada 5 segundos), al segundo grupo a una velocidad media (1 palabra cada 2 segundos) y al tercer grupo a alta velocidad (1 palabra por segundo). Se predijo que el rendimiento de la reproducción dependería de la velocidad de presentación de las palabras. Los resultados se presentan en la Tabla. 1.

Número de palabras reproducidas tabla 1

|

Asunto No. |

velocidad media |

alta velocidad |

|

|

cantidad total | |||

H 0: Diferencias en la duración de la producción de palabras entre Los grupos no son más pronunciados que las diferencias aleatorias. adentro cada grupo.

H1: Diferencias en el volumen de producción de palabras. entre Los grupos son más pronunciados que las diferencias aleatorias. adentro cada grupo. Utilizando los valores experimentales presentados en la Tabla. 1, estableceremos algunos valores que serán necesarios para calcular el criterio F.

El cálculo de las principales cantidades para el análisis de varianza unidireccional se presenta en la tabla:

Tabla 2

Tabla 3

Secuencia de operaciones en análisis de varianza unidireccional para muestras no relacionadas

La designación SS, que a menudo se encuentra en esta y en las siguientes tablas, es una abreviatura de "suma de cuadrados". Esta abreviatura se utiliza con mayor frecuencia en fuentes traducidas.

SS hecho significa la variabilidad de la característica debido a la acción del factor en estudio;

SS generalmente- variabilidad general del rasgo;

S CALIFORNIA.-variabilidad debida a factores no contabilizados, variabilidad “aleatoria” o “residual”.

EM- “cuadrado medio”, o la expectativa matemática de la suma de cuadrados, el valor promedio del SS correspondiente.

df - el número de grados de libertad, que, al considerar criterios no paramétricos, denotamos con una letra griega v.

Conclusión: se rechaza H 0. Se acepta H 1. Las diferencias en el recuerdo de palabras entre los grupos fueron mayores que las diferencias aleatorias dentro de cada grupo (α=0,05). Entonces, la velocidad de presentación de las palabras afecta el volumen de su reproducción.

A continuación se presenta un ejemplo de resolución del problema en Excel:

Datos iniciales:

Usando el comando: Herramientas->Análisis de datos->ANOVA unidireccional, obtenemos los siguientes resultados:

El uso de estadísticas en esta nota se ilustrará con un ejemplo transversal. Digamos que eres el director de producción de Perfect Parachute. Los paracaídas están fabricados con fibras sintéticas suministradas por cuatro proveedores diferentes. Una de las principales características de un paracaídas es su resistencia. Debe asegurarse de que todas las fibras suministradas tengan la misma resistencia. Para responder a esta pregunta, se debe diseñar un diseño experimental para medir la resistencia de los paracaídas tejidos con fibras sintéticas. diferentes proveedores. La información obtenida de este experimento determinará qué proveedor proporciona los paracaídas más duraderos.

Muchas aplicaciones implican experimentos que consideran múltiples grupos o niveles de un solo factor. Algunos factores, como la temperatura de cocción de la cerámica, pueden tener múltiples niveles numéricos (es decir, 300°, 350°, 400° y 450°). Otros factores, como la ubicación de los artículos en un supermercado, pueden tener niveles categóricos (por ejemplo, primer proveedor, segundo proveedor, tercer proveedor, cuarto proveedor). Los experimentos de un solo factor en los que las unidades experimentales se asignan aleatoriamente a grupos o niveles de factores se denominan completamente aleatorios.

UsoF-criterios para evaluar las diferencias entre varias expectativas matemáticas

Si las medidas numéricas de un factor en grupos son continuas y algunas condiciones adicionales, para comparar las expectativas matemáticas de varios grupos, análisis de varianza (ANOVA - Un análisis oh F Virginia rianza). El análisis de varianza utilizando diseños completamente aleatorios se denomina procedimiento ANOVA unidireccional. En cierto modo, el término análisis de varianza es un nombre inapropiado porque compara diferencias entre los valores esperados de grupos en lugar de entre varianzas. Sin embargo, la comparación de expectativas matemáticas se realiza precisamente sobre la base de un análisis de variación de datos. En el procedimiento ANOVA, la variación total en los resultados de la medición se divide entre grupos y dentro de grupos (Fig. 1). La variación dentro del grupo se explica por el error experimental, y la variación entre grupos se explica por los efectos de las condiciones experimentales. Símbolo Con denota el número de grupos.

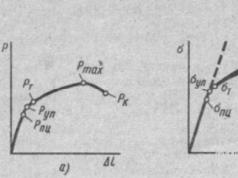

Arroz. 1. Variación de partición en un experimento completamente aleatorio

Descarga la nota en formato o, ejemplos en formato

pretendamos que Con grupos extraídos de independientes poblaciones generales, teniendo una distribución normal y la misma varianza. La hipótesis nula es que las expectativas matemáticas de las poblaciones son las mismas: H 0: μ 1 = μ 2 = ... = μ s. La hipótesis alternativa establece que no todas las expectativas matemáticas son iguales: H 1: no todos los μ j son iguales j= 1, 2,…, s).

En la Fig. La Figura 2 presenta la verdadera hipótesis nula sobre las expectativas matemáticas de los cinco grupos comparados, siempre que las poblaciones tengan una distribución normal y la misma varianza. Cinco poblaciones generales asociadas con en diferentes niveles Los factores son idénticos. En consecuencia, se superponen unos a otros, teniendo la misma expectativa, variación y forma matemática.

Arroz. 2. Cinco poblaciones generales tienen la misma expectativa matemática: μ 1 = μ 2 = μ 3 = μ 4 = μ 5

Por otro lado, supongamos que, de hecho, la hipótesis nula es falsa, donde el cuarto nivel tiene el valor esperado más alto, el primer nivel tiene un valor esperado ligeramente más bajo y los niveles restantes tienen los mismos valores esperados e incluso más bajos ( Figura 3). Tenga en cuenta que, con excepción de los valores esperados, las cinco poblaciones son idénticas (es decir, tienen la misma variabilidad y forma).

Arroz. 3. Se observa el efecto de las condiciones experimentales: μ 4 > μ 1 > μ 2 = μ 3 = μ 5

Al probar la hipótesis sobre la igualdad de expectativas matemáticas de varias poblaciones generales, la variación total se divide en dos partes: variación intergrupal, debida a diferencias entre grupos, y variación intragrupal, debida a diferencias entre elementos pertenecientes a un mismo grupo. La variación total se expresa por la suma total de cuadrados (SST – suma de cuadrados total). Dado que la hipótesis nula es que las expectativas matemáticas de todos Con Los grupos son iguales entre sí, la variación total es igual a la suma de las diferencias al cuadrado entre las observaciones individuales y el promedio general (promedio de promedios), calculado para todas las muestras. Variación completa:

Dónde ![]() - promedio general, X ij - i-e observación en j-grupo o nivel, nj- número de observaciones en jº grupo, norte - total observaciones en todos los grupos (es decir, norte = norte 1

+ norte 2 + … + n c), Con- número de grupos o niveles estudiados.

- promedio general, X ij - i-e observación en j-grupo o nivel, nj- número de observaciones en jº grupo, norte - total observaciones en todos los grupos (es decir, norte = norte 1

+ norte 2 + … + n c), Con- número de grupos o niveles estudiados.

Variación entre grupos, generalmente llamada suma de cuadrados entre grupos (SSA - suma de cuadrados entre grupos), es igual a la suma de cuadrados de las diferencias entre las medias muestrales de cada grupo j y promedio general , multiplicado por el volumen del grupo correspondiente nj:

Dónde Con- número de grupos o niveles estudiados, nj- número de observaciones en jº grupo, j- valor promedio jº grupo, - media general.

Variación dentro del grupo, generalmente llamada suma de cuadrados dentro del grupo (SSW - suma de cuadrados dentro de grupos), es igual a la suma de cuadrados de las diferencias entre los elementos de cada grupo y la media muestral de este grupo j:

Dónde Xyo - i elemento jº grupo, j- valor promedio jº grupo.

ya que se comparan Con niveles de factores, la suma de cuadrados intergrupo tiene s – 1 grados de libertad. Cada uno de Con niveles tiene nj – 1 grados de libertad, por lo que la suma de cuadrados intragrupo tiene norte- Con grados de libertad y

Además, la suma total de cuadrados tiene norte – 1 grados de libertad, ya que cada observación Xyo se compara con el promedio general calculado sobre todos norte observaciones. Si se divide cada una de estas sumas por el número correspondiente de grados de libertad, surgen tres tipos de dispersión: intergrupo(media cuadrática entre - MSA), intragrupo(media cuadrática dentro de - RSU) y lleno(media cuadrática total - MST):

A pesar de que el objetivo principal del análisis de varianza es comparar expectativas matemáticas Con grupos para revelar el efecto de las condiciones experimentales, su nombre se debe a que la herramienta principal es el análisis de varianzas diferentes tipos. Si la hipótesis nula es cierta y entre las expectativas matemáticas Con En los grupos no hay diferencias significativas, las tres varianzas (MSA, MSW y MST) son estimaciones de varianza. s 2 inherente a los datos analizados. Por lo tanto, para probar la hipótesis nula H 0: μ 1 = μ 2 = ... = μ s e hipótesis alternativa H 1: no todos los μ j son iguales j = 1, 2, …, Con), es necesario calcular estadísticas F-criterio, que es la relación de dos varianzas, MSA y RSU. Prueba F-estadísticas en análisis de varianza unidireccional

Estadísticas F-sujeto a criterios F-distribución con s – 1 grados de libertad en el numerador M.S.A. Y norte – s grados de libertad en el denominador MSW. Para un nivel de significancia dado α, la hipótesis nula se rechaza si el valor calculado F FUd., inherente F-distribución con s – 1 norte – s grados de libertad en el denominador. Así, como se muestra en la Fig. 4, regla decisiva formulado de la siguiente manera: hipótesis nula H 0 rechazado si F>FUd.; en caso contrario no se rechaza.

Arroz. 4. Área crítica del análisis de varianza al probar una hipótesis H 0

Si la hipótesis nula H 0 es cierto, calculado F-la estadística es cercana a 1, ya que su numerador y denominador son estimaciones de la misma cantidad: la dispersión σ 2 inherente a los datos analizados. Si la hipótesis nula H 0 es falso (y hay una diferencia significativa entre las expectativas matemáticas de diferentes grupos), calculado F-La estadística será mucho mayor que uno porque su numerador, MSA, estima, además de la variabilidad natural de los datos, el efecto de las condiciones experimentales o la diferencia entre grupos, mientras que el denominador MSW estima sólo la variabilidad natural de los datos. . Por tanto, el procedimiento ANOVA es F-criterio en el que, para un nivel de significancia dado α, se rechaza la hipótesis nula si el valor calculado F-las estadísticas son mayores que el valor crítico superior FUd., inherente F-distribución con s – 1 grados de libertad en el numerador y norte – s grados de libertad en el denominador, como se muestra en la Fig. 4.

Para ilustrar el análisis unidireccional de la varianza, volvamos al escenario descrito al principio de la nota. El objetivo del experimento es determinar si los paracaídas tejidos con fibras sintéticas obtenidas de diferentes proveedores tienen la misma resistencia. Cada grupo tiene cinco paracaídas. Los grupos se dividen por a proveedores - Proveedor 1, Proveedor 2, Proveedor 3 y Proveedor 4. La resistencia de los paracaídas se mide utilizando un dispositivo especial que prueba la tela para rasgarse en ambos lados. La fuerza necesaria para romper un paracaídas se mide con una escala especial. Cuanto mayor sea la fuerza de rotura, más fuerte será el paracaídas. Excel te permite analizar F-Estadísticas en un clic. Pasa por el menú Datos → Análisis de los datos y seleccione la línea ANOVA unidireccional, complete la ventana que se abre (Fig. 5). Los resultados experimentales (resistencia a la rotura), algunas estadísticas descriptivas y los resultados del análisis de varianza unidireccional se presentan en la Fig. 6.

Arroz. 5. ventana Paquete de análisis unidireccional de análisis de varianza Sobresalir

Arroz. 6. Indicadores de resistencia de paracaídas tejidos con fibras sintéticas obtenidos de diferentes proveedores, estadísticas descriptivas y resultados del análisis de varianza unidireccional.

El análisis de la Figura 6 muestra que existe alguna diferencia entre las medias muestrales. La resistencia media de las fibras obtenidas del primer proveedor es 19,52, del segundo - 24,26, del tercero - 22,84 y del cuarto - 21,16. ¿Es esta diferencia estadísticamente significativa? La distribución de la fuerza de ruptura se demuestra en el diagrama de dispersión (Fig. 7). Muestra claramente diferencias tanto entre grupos como dentro de ellos. Si cada grupo fuera de mayor tamaño, se podría utilizar un diagrama de tallo y hojas, un diagrama de caja o un diagrama de campana para analizarlos.

Arroz. 7. Diagrama de dispersión de resistencias para paracaídas tejidos con fibras sintéticas obtenidas de cuatro proveedores.

La hipótesis nula establece que no existen diferencias significativas entre las puntuaciones medias de fuerza: H 0: μ 1 = μ 2 = μ 3 = μ 4. Una hipótesis alternativa es que existe al menos un proveedor cuya resistencia promedio de la fibra difiere de los demás: H 1: no todos los μ j son iguales ( j = 1, 2, …, Con).

Promedio general (ver Fig. 6) = PROMEDIO(D12:D15) = 21,945; para determinarlo, también puedes promediar los 20 números originales: = PROMEDIO(A3:D7). Se calculan los valores de varianza. Paquete de análisis y se reflejan en la placa Análisis de variación(ver Fig. 6): SSA = 63.286, SSW = 97.504, SST = 160.790 (ver columna SS mesas Análisis de variación Figura 6). Los promedios se calculan dividiendo estas sumas de cuadrados por el número apropiado de grados de libertad. Porque el Con= 4, un norte= 20, obtenemos los siguientes valores de grados de libertad; para SSA: s – 1= 3; para SSW: Carolina del Norte= 16; para SST: norte – 1= 19 (ver columna df). Así: MSA = SSA / ( s-1)= 21,095; RSU = SSW / ( Carolina del Norte) = 6,094; MST = TSM / ( norte – 1) = 8,463 (ver columna EM). F-estadísticas = MSA / MSW = 3.462 (ver columna F).

Valor crítico superior FUd., caracteristico de F-distribución, determinada por la fórmula =F.OBR(0,95;3;16) = 3,239. Parámetros de la función =F.OBR(): α = 0,05, el numerador tiene tres grados de libertad y el denominador tiene 16. Por lo tanto, el calculado F-la estadística igual a 3.462 excede el valor crítico superior FUd.= 3,239, se rechaza la hipótesis nula (Fig. 8).

Arroz. 8. Región crítica de análisis de varianza a un nivel de significancia de 0,05 si el numerador tiene tres grados de libertad y el denominador es -16

R-valor, es decir la probabilidad de que si la hipótesis nula es cierta F-estadísticas no inferiores a 3,46, igual a 0,041 o 4,1% (ver columna valor p mesas Análisis de variación Figura 6). Dado que este valor no supera el nivel de significancia α = 5%, se rechaza la hipótesis nula. Además, R-El valor indica que la probabilidad de detectar tal o mayor diferencia entre las expectativas matemáticas de la población general, siempre que en realidad sean iguales, es igual al 4,1%.

Entonces. Hay una diferencia entre las cuatro medias muestrales. La hipótesis nula fue que todas las expectativas matemáticas de las cuatro poblaciones son iguales. En estas condiciones, se calcula una medida de la variabilidad total (es decir, la variación total de la SST) de la fuerza de todos los paracaídas sumando las diferencias al cuadrado entre cada observación. X ij y promedio general . Luego, la variación total se separó en dos componentes (ver Fig. 1). El primer componente fue la variación entre grupos en SSA y el segundo fue la variación dentro del grupo en SSW.

¿Qué explica la variabilidad de los datos? En otras palabras, ¿por qué no todas las observaciones son iguales? Una razón es que diferentes empresas suministran fibras de diferente resistencia. Esto explica en parte por qué los grupos tienen diferentes expectativas matemáticas: cuanto más fuerte es el efecto de las condiciones experimentales, mayor es la diferencia entre las expectativas matemáticas de los grupos. Otra razón para la variabilidad de los datos es la variabilidad natural de cualquier proceso, en en este caso- producción de paracaídas. Incluso si todas las fibras se compraran del mismo proveedor, su resistencia no sería la misma, en igualdad de condiciones. Debido a que este efecto ocurre dentro de cada grupo, se le llama variación dentro del grupo.

Las diferencias entre las medias muestrales se denominan variación intergrupal SSA. Parte de la variación intragrupo, como ya se indicó, se explica por la afiliación de los datos diferentes grupos. Sin embargo, incluso si los grupos fueran exactamente iguales (es decir, la hipótesis nula fuera cierta), aún existiría variación entre grupos. La razón de esto es la variabilidad natural del proceso de fabricación de paracaídas. Debido a que las muestras son diferentes, sus medias muestrales difieren entre sí. Por lo tanto, si la hipótesis nula es cierta, tanto la variabilidad entre grupos como dentro de los grupos representan una estimación de la variabilidad de la población. Si la hipótesis nula es falsa, la hipótesis entre grupos será mayor. Es este hecho el que subyace F-criterios para comparar diferencias entre las expectativas matemáticas de varios grupos.

Después de realizar un ANOVA unidireccional y encontrar una diferencia significativa entre empresas, aún se desconoce qué proveedor es significativamente diferente de los demás. Sólo sabemos que las expectativas matemáticas de la población general no son iguales. En otras palabras, al menos una de las expectativas matemáticas es significativamente diferente de las demás. Para determinar qué proveedor es diferente de los demás, puede utilizar procedimiento de tukey, utilizando comparaciones por pares entre proveedores. Este procedimiento fue desarrollado por John Tukey. Posteriormente, él y K. Kramer modificaron de forma independiente este procedimiento para situaciones en las que los tamaños de muestra difieren entre sí.

Comparación múltiple: procedimiento de Tukey-Kramer

En nuestro escenario, se utilizó un análisis de varianza unidireccional para comparar la fuerza de los paracaídas. Habiendo encontrado diferencias significativas entre las expectativas matemáticas de los cuatro grupos, es necesario determinar qué grupos difieren entre sí. Aunque hay varias formas de resolver este problema, sólo describiremos el procedimiento de comparación múltiple de Tukey-Kramer. Este método es un ejemplo de procedimientos de comparación post hoc porque la hipótesis que se prueba se formula después del análisis de los datos. El procedimiento de Tukey-Kramer permite comparar todos los pares de grupos simultáneamente. En la primera etapa se calculan las diferencias. Xj -Xj ’ , Dónde j ≠j’ , entre expectativas matemáticas s(s – 1)/2 grupos. Alcance crítico El procedimiento de Tukey-Kramer se calcula mediante la fórmula:

Dónde Q U- el valor crítico superior de la distribución de rango estudentizado, que tiene Con grados de libertad en el numerador y norte - Con grados de libertad en el denominador.

Si los tamaños de muestra no son los mismos, el rango crítico se calcula para cada par de expectativas matemáticas por separado. En la última etapa, cada uno de s(s – 1)/2 Se comparan pares de expectativas matemáticas con el rango crítico correspondiente. Los elementos de un par se consideran significativamente diferentes si el módulo de diferencia | xj -Xj ’ | entre ellos excede el rango crítico.

Apliquemos el procedimiento de Tukey-Kramer al problema de la resistencia de los paracaídas. Dado que la empresa de paracaídas tiene cuatro proveedores, hay 4(4 – 1)/2 = 6 pares de proveedores para verificar (Figura 9).

Arroz. 9. Comparaciones por pares de medias muestrales

Dado que todos los grupos tienen el mismo volumen (es decir, todos nj = nj ’ ), basta con calcular solo un rango crítico. Para ello, según la tabla. ANOVA(Fig. 6) determinamos el valor RSU = 6,094. Luego encontramos el valor Q U en α = 0,05, Con= 4 (número de grados de libertad en el numerador) y norte- Con= 20 – 4 = 16 (el número de grados de libertad en el denominador). Lamentablemente no encontré la función correspondiente en Excel, así que utilicé la tabla (Fig. 10).

Arroz. 10. Valor crítico alcance estudentizado Q U

Obtenemos:

Dado que sólo 4,74 > 4,47 (ver tabla inferior de la Fig. 9), existe una diferencia estadísticamente significativa entre el primer y el segundo proveedor. Todos los demás pares tienen medios muestrales que no nos permiten hablar de sus diferencias. En consecuencia, la resistencia media de los paracaídas tejidos con fibras compradas al primer proveedor es significativamente menor que la del segundo.

Condiciones necesarias para el análisis de varianza unidireccional

Al resolver el problema de la resistencia de los paracaídas, no verificamos si se cumplen las condiciones bajo las cuales es posible utilizar un factor único. F-criterio. ¿Cómo sabes si puedes usar un factor? F-criterio al analizar datos experimentales específicos? Factor único F-El criterio sólo se puede aplicar si se cumplen tres supuestos básicos: los datos experimentales deben ser aleatorios e independientes, tener una distribución normal y sus varianzas deben ser iguales.

Primera suposición - aleatoriedad e independencia de los datos- siempre debe realizarse, ya que la exactitud de cualquier experimento depende de la aleatoriedad de la elección y/o del proceso de aleatorización. Para evitar sesgar los resultados, es necesario que los datos se extraigan de Con poblaciones generales de forma aleatoria e independiente unas de otras. De manera similar, los datos deben distribuirse aleatoriamente entre Con niveles del factor que nos interesa (grupos experimentales). La violación de estas condiciones puede distorsionar gravemente los resultados del análisis de varianza.

Adivinar - normalidad- significa que los datos se extraen de poblaciones distribuidas normalmente. Como para t-criterios, análisis de varianza unidireccional basado en F-Los criterios son relativamente poco sensibles a la violación de esta condición. Si la distribución no se desvía demasiado significativamente de lo normal, el nivel de significancia F-El criterio cambia poco, especialmente si el tamaño de la muestra es lo suficientemente grande. Si se viola gravemente la condición de normalidad de distribución, se debe aplicar.

Tercera suposición homogeneidad de varianza- significa que las varianzas de cada población son iguales entre sí (es decir, σ 1 2 = σ 2 2 = ... = σ j 2). Este supuesto permite decidir si separar o agrupar las variaciones dentro del grupo. Si los tamaños de los grupos son iguales, la condición de homogeneidad de la varianza tiene poco efecto en las conclusiones obtenidas utilizando F-criterios. Sin embargo, si los tamaños de muestra son desiguales, la violación de la condición de igualdad de varianzas puede distorsionar gravemente los resultados del análisis de varianza. Por lo tanto, se deben hacer esfuerzos para garantizar que los tamaños de muestra sean iguales. Uno de los métodos para verificar el supuesto de homogeneidad de la varianza es el criterio levene descrito abajo.

Si, de las tres condiciones, sólo se viola la condición de homogeneidad de la varianza, se utiliza un procedimiento similar a t-criterio que utiliza varianza separada (para más detalles, ver). Sin embargo, si las suposiciones sobre distribución normal y al mismo tiempo se viola la homogeneidad de la varianza, es necesario normalizar los datos y reducir las diferencias entre las varianzas o aplicar un procedimiento no paramétrico.

Prueba de Levene para probar la homogeneidad de la varianza

A pesar de F-el criterio es relativamente resistente a violaciones de la condición de igualdad de varianzas en grupos; una violación grave de este supuesto afecta significativamente el nivel de significancia y poder del criterio. Quizás uno de los más poderosos sea el criterio levene. Para comprobar la igualdad de varianzas Con poblaciones generales, probaremos las siguientes hipótesis:

Н 0: σ 1 2 = σ 2 2 = … = σj 2

H 1: No todo σ j 2 son lo mismo ( j = 1, 2, …, Con)

La prueba de Levene modificada se basa en la afirmación de que si la variabilidad en los grupos es la misma, el análisis de varianza de los valores absolutos de las diferencias entre observaciones y medianas de grupo se puede utilizar para probar la hipótesis nula de igualdad de varianzas. Por lo tanto, primero debe calcular los valores absolutos de las diferencias entre observaciones y medianas en cada grupo, y luego realizar un análisis de varianza unidireccional sobre los valores absolutos resultantes de las diferencias. Para ilustrar el criterio de Levene, volvamos al escenario esbozado al inicio de la nota. Utilizando los datos presentados en la Fig. 6, realizaremos un análisis similar, pero en relación a los módulos de diferencias en los datos iniciales y medianas para cada muestra por separado (Fig. 11).